Tarook ist ein auf Ansible, Nix und Terraform basierendes holistisches Lifecycle Management Tooling für eine flexible, anpassbare, hochverfügbare und skalierbare kubeadm-basierte Kubernetes Distribution – sowohl auf OpenStack als auch direkt auf Bare-Metal.

Die Installation und Konfiguration eines Kubernetes-Clusters kann besonders bei Anforderungen an Skalierbarkeit und Hochverfügbarkeit sehr komplex sein.

Das Kubernetes-Ökosystem entwickelt sich rasant weiter, was es zu einer Herausforderung macht, mit neuen Tools, Updates und Best Practices Schritt zu halten.

Dank der integrierten Funktionen für Skalierbarkeit und Hochverfügbarkeit kannst du deine Kubernetes-Cluster problemlos an deine wachsenden Anforderungen anpassen.

Tarook sorgt dafür, dass deine Cluster nach Best Practices verwaltet werden, sodass du schnell auf neue Entwicklungen reagieren kannst. Es übernimmt den Lebenszyklus von Kubernetes und allen zugehörigen Services und sorgt mit regelmäßigen Updates für verbesserte Funktionen und eine höhere Sicherheit.

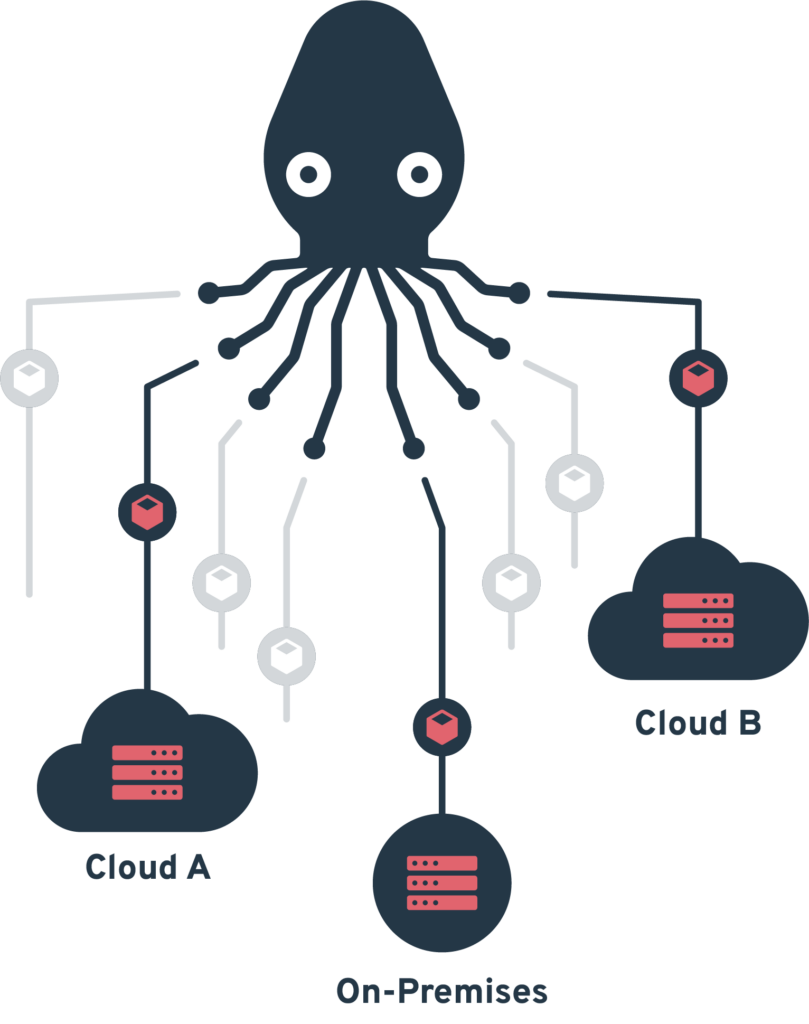

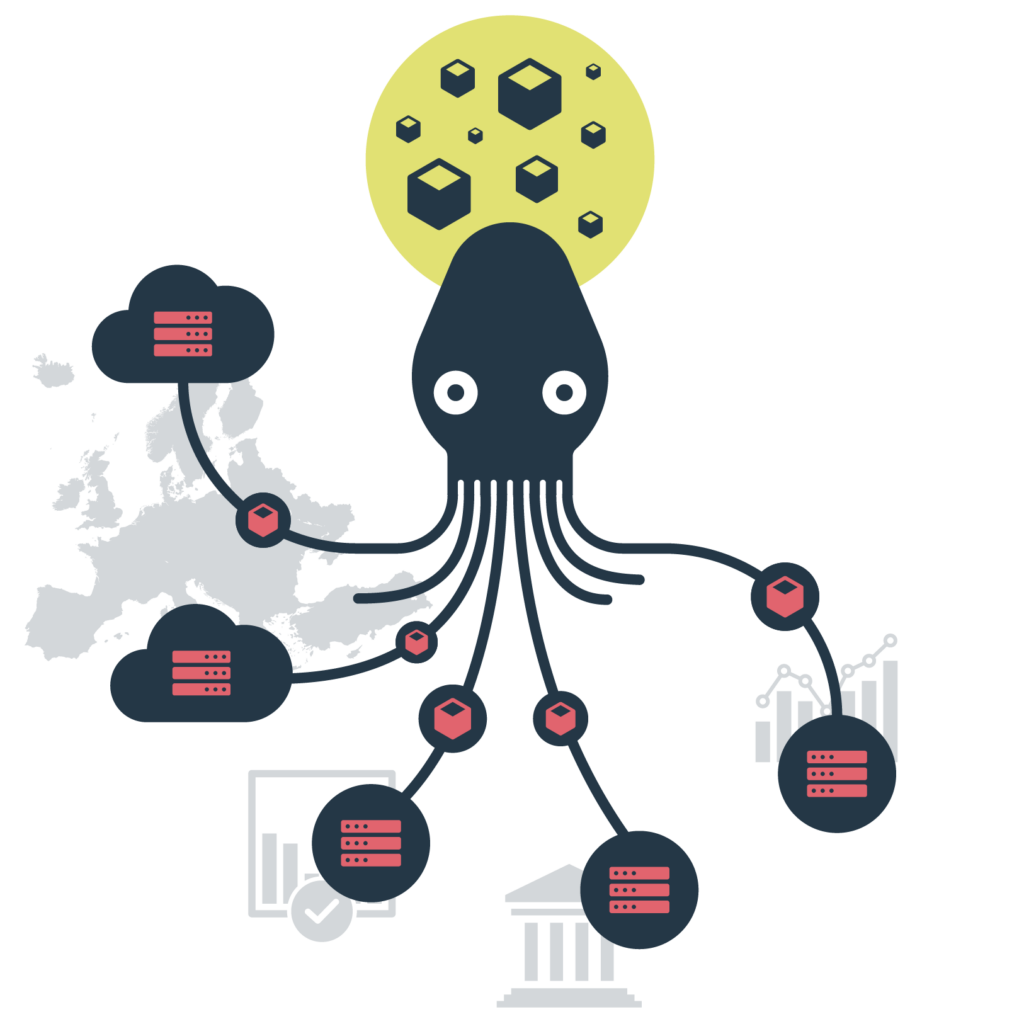

Bereitstellung, Verwaltung und Skalierung von Kubernetes-Clustern auf Bare-Metal oder OpenStack. Unabhängig vom Einsatzbereich bietet es eine flexible, automatisierte Lösung für das vollständige Life-Cycle-Management von Kubernetes und sorgt so für eine effiziente Betriebsführung.

Einheitliche Schnittstelle zur Verwaltung verteilter Kubernetes-Cluster über eine zentrale Abstraktionsebene.

Mikroservice-basierte Komponenten ermöglichen flexible Anpassung und Integration eigener Entwicklungen in die Orchestrierungs-Pipeline.

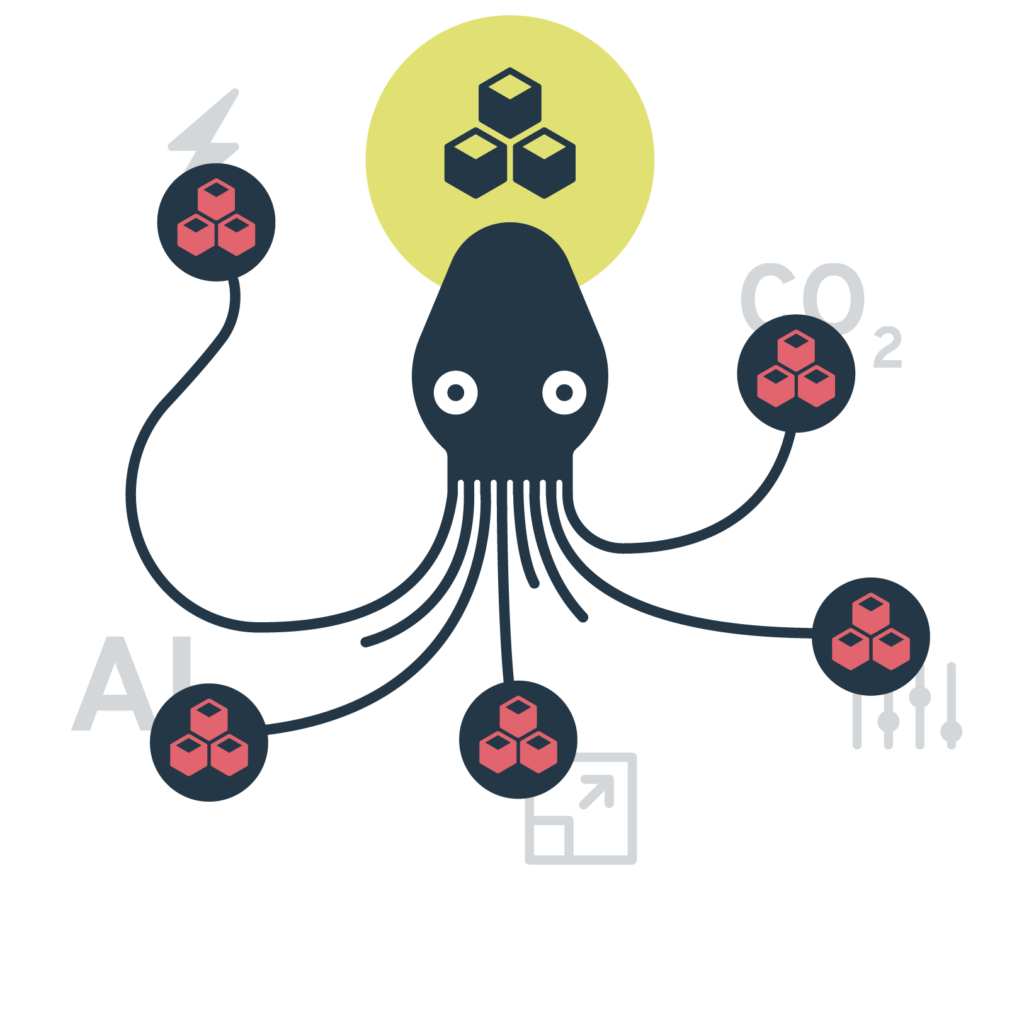

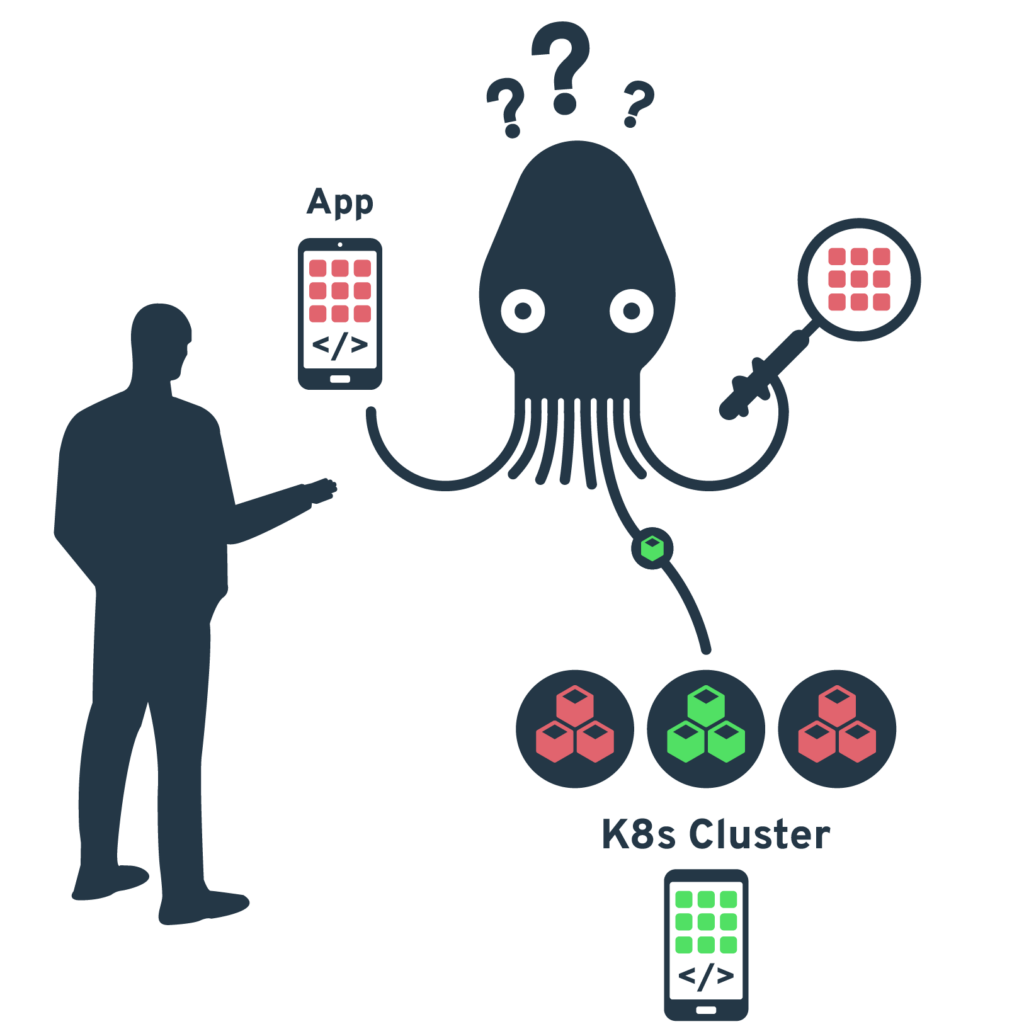

Orchestrierung von Kubernetes-Workloads über verschiedene Cluster und Standorte hinweg.

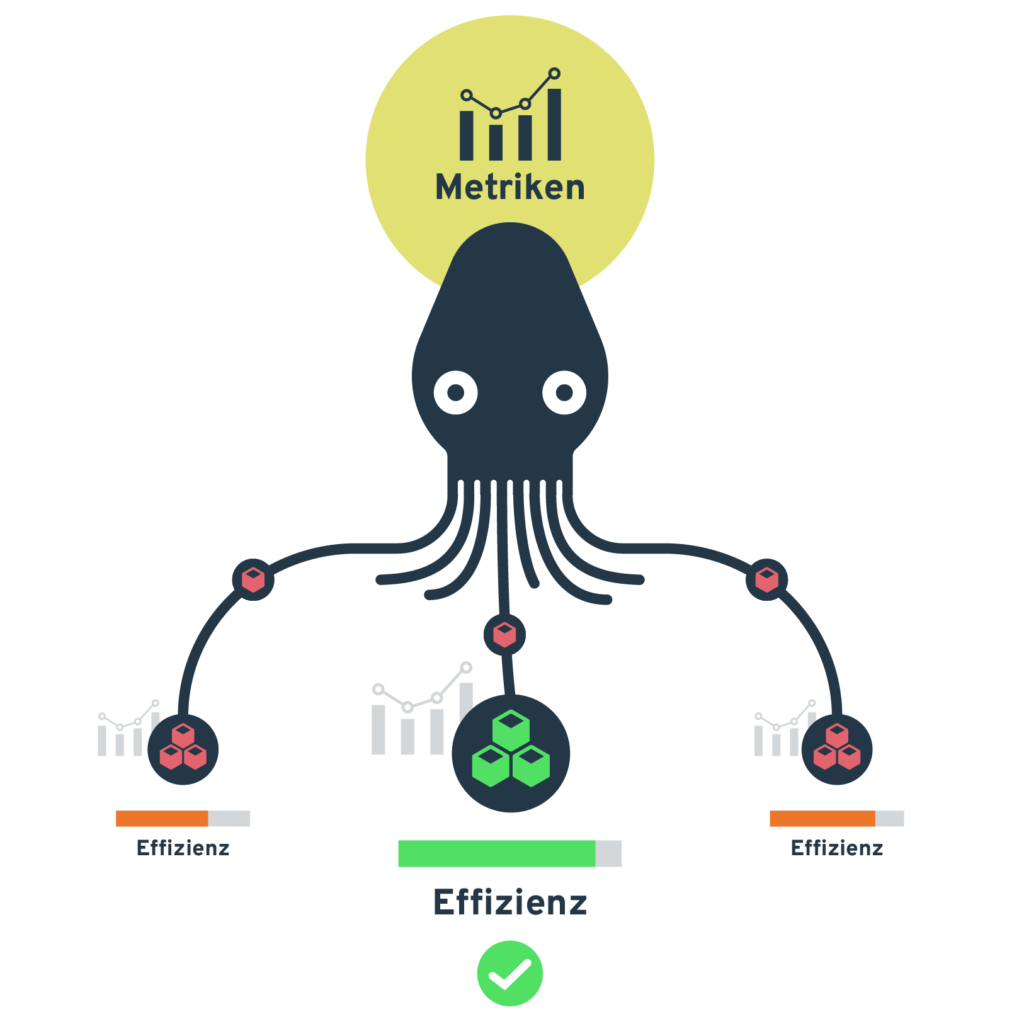

Automatisierte Container-Workload-Verteilung basierend auf konfigurierbaren Metriken wie Latenz, Energie und Kosten und nutzerdefinierten Parametern.

Feingranulare Kontrolle der Workload-Verteilung durch benutzerdefinierte Labels und Constraints.

Orchestrierung sowohl zustandsloser als auch zustandsbehafteter Container-Anwendungen – von Microservices bis zu komplexen Datenbanksystemen.

Automatisierte Bereitstellung und Skalierung von Kubernetes-Clustern über verschiedene Infrastruktur-Provider.

Krake ist vollständig quelloffen und ermöglicht Zusammenarbeit und Transparenz bei jedem Schritt.

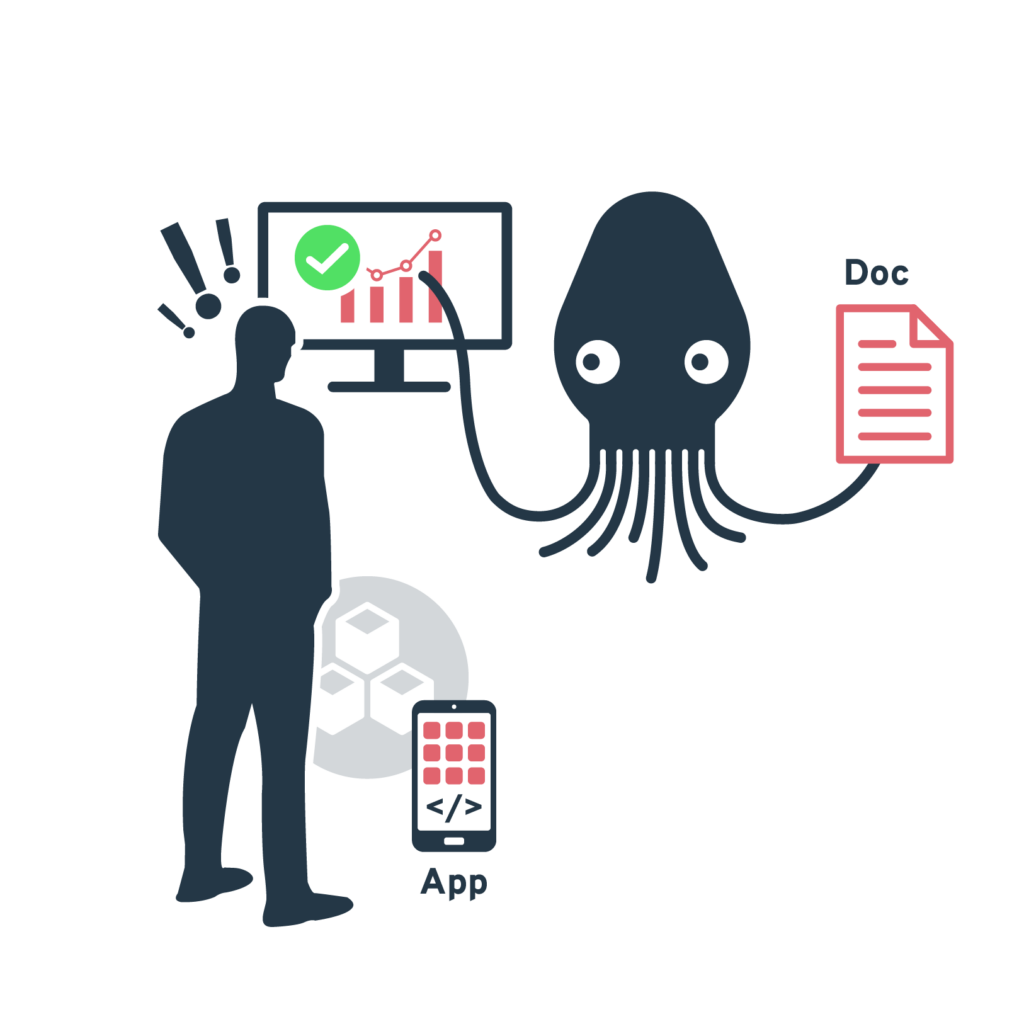

Definiere deine individuellen Metriken und Metrics Provider (z.B. Prometheus). Diese bestimmen, nach welchen Kriterien Krake deine Workloadplatzierung optimiert.

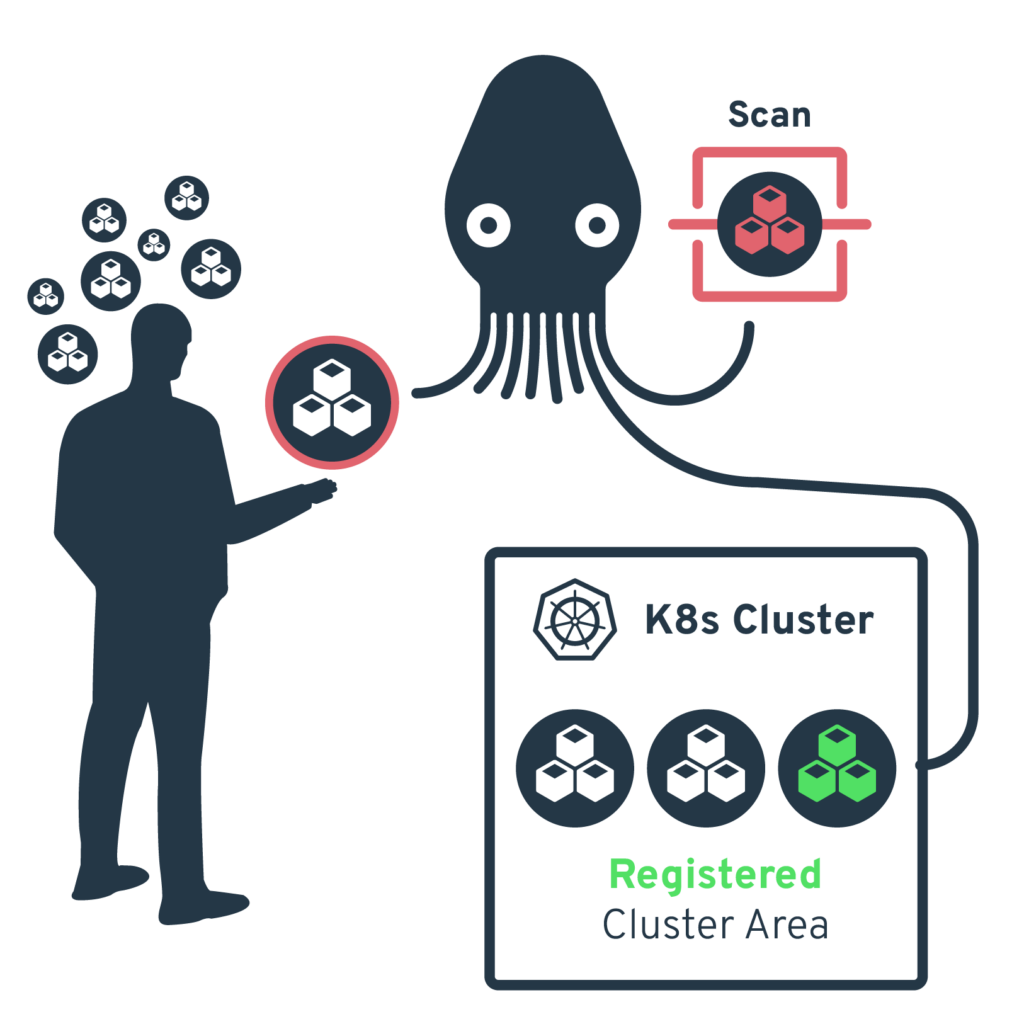

Registriere deine Kubernetes-Cluster bei Krake. Die Cluster können sowohl lokal als auch in der Cloud betrieben werden.

Rollout deiner containerisierten Anwendungen. Krake analysiert die definierten Metriken und platziert die Workloads automatisch auf den am besten geeigneten Clustern.

Krake überwacht kontinuierlich die Metriken und passt die Platzierung der Workloads bei Bedarf automatisch an – für optimale Performance und Ressourcennutzung.

Wir möchten uns an dieser Stelle herzlich bei allen bedanken, die uns beim Voting unterstützt und für Krake gestimmt haben.

Mit Krake lassen sich Cloud- & Kubernetes-Cluster-Ressourcen ansteuern, um Arbeitslasten auf diesen zu verteilen. Darüber hinaus bietet Krake aber auch die Möglichkeit Kubernetes-Cluster-Ressourcen über weitere Tools erzeugen zu lassen. Aktuell wird diese Funktion in Krake durch den Infrastructure Manager (IM) unterstützt. Für das Erzeugen von Cloud-Ressourcen (OpenStack) ist ein ähnlicher Ansatz mit Yaook geplant und befindet sich gerade in Umsetzung.

Im Januar 2025 fand Tarook sein neues Zuhause bei ALASCA – einem gemeinnützigen Verein für die (Weiter)entwicklung betriebsfähiger, offener Cloud-Infrastrukturen. Die Mission von ALASCA dreht sich um die Weiterentwicklung und Bereitstellung von Open-Source Tools, die den Aufbau und Betrieb eigener Cloud-Infrastrukturen nicht nur ermöglichen, sondern auch erleichtern.

Neben der praktischen Entwicklungsarbeit an diesen Projekten versteht sich ALASCA auch als Vermittler von Wissen rund um diese Themen – nicht nur innerhalb des Vereins, sondern auch nach außen hin, wie beispielsweise in Form der ALASCA Tech-Talks.

Mit einer starken, motivierten Community und der geballten Kompetenz der Vereinsmitglieder treibt ALASCA die digitale Souveränität in Deutschland und Europa damit nachhaltig voran – auch in Zusammenarbeit mit weiteren Open-Source-Initiativen und -Communities der digitalen Branche.

ALASCA – Verband für betriebsfähige, offene Cloud-Infrastrukturen e.V.

c/o Cloud&Heat Technologies GmbH

Zeitenströmung – Halle 15

Königsbrücker Str. 96

01099 Dresden, Germany

Phone: +49 351 479 367 00

Email: hello@alasca.cloud

Web: alasca.cloud